Дубли страниц, что это такое, какое влияние они оказывают на поисковое продвижение сайта и как можно избежать этих дублей. Все эти вопросы по понятным причинам волнуют сайтостроителей.

Дубли страниц, что это такое, какое влияние они оказывают на поисковое продвижение сайта и как можно избежать этих дублей. Все эти вопросы по понятным причинам волнуют сайтостроителей.

Содержание:

Что такое дубли страниц

Если открыть главную страницу блога, то, как обычно, увидим анонсы последних записей. Часто бывает так, что если набрать в поисковой строке адрес домена/page/1, то есть страница первая, то можно увидеть здесь то же самое содержимое, что и на главной странице сайта.

Это явление и называется дубли контента, то есть страницы с частично или полностью повторяющимся содержимым.

То, что дубли страниц не приносят ничего хорошего сайту, можно догадаться ничего больше не зная о них. Таких дублей на самом деле может быть очень много.

Каждая страница сайта обладает каким-то статическим весом, что непосредственно напрямую влияет на ее позиции в выдаче. Если на том же самом хосте появляется дубликат страницы, то статический вес страницы размывается.

Контент на странице становится для поисковых систем не уникальным, и они задерживают или занижают позиции страниц в выдаче. Поэтому нужно как можно раньше начать бороться с проблемой наличия дублей на сайте.

Откуда дубли вообще берутся? В большинстве случаев они генерируются самой системой WordPress. Это различные категории, метки, результаты поиска, комментарии и другое.

Не будем говорить, что виновата в этом система движка. Скорее всего, вина исходит от того, кто настраивал или наоборот не настраивал ее.

Первое, что нужно проверить, настроен ли редирект со второстепенного зеркала сайта на главное. Для этого перед URL главной страницы сайта введем тройное www.

Если открывается та же самая страница, значит редирект на главное зеркало не настроен, поэтому страницы с www и без www являются полными дублями.

Таким образом, все страницы сайта, по сути, дублируются. Это конечно нехорошо и надо все исправить. Исправить это можно либо в настройках web-сервера, либо в файле .htaccess.txt. Проверить также нужно страницы index.php и index.html.

Для этого на главной странице сайта в адресной строке введем https://webentrance.ru/index.php. Снова открывается та же самая страница. Проверим https://webentrance.ru/index.html, здесь такой страницы не существует.

Затем можно зайти в какой-либо раздел, например, Windows-7. Нужно проверить, есть ли редирект со страниц со слешем. То есть, если приставить к адресу страницы слеш и открывается та же самая страница, то так же необходимо сделать редирект через настройки веб-сервера.

Откроем любую страницу и посмотрим, что изменится, если к адресу ввести .html или .php. Открывается та же самая страница. Введем в адрес страницы случайные символы. Если открывается та же страница, то это значит, что не работает на сайте перенаправление на страницу с 404 ошибкой.

Еще несколько вещей, которые могут привести к дублям на вашем сайте. Это страницы с сортировкой, группировкой или фильтром какого-то товара. Все они имеют различные приставки к URL в виде различных параметров. Эти параметры собственно и создают дубликаты страниц.

Нужно помнить, что любой URL, который отличается от текущего, является другой страницей. Пусть даже их содержание абсолютно идентично. Поэтому такие страницы нужно закрывать в файле robots.txt, чтобы поисковый робот их не видел. И чтобы они ни в коем случае не попадали в индекс поисковых систем.

Вот основные причины, по которым появляются дубликаты страниц. Здесь может быть, как уже говорилось, два решения:

1. Закрыть их в robots.txt.

2. Решить проблему с помощью файла .htaccess.txt.

Ищем дубли страниц

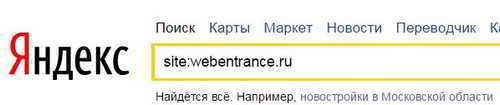

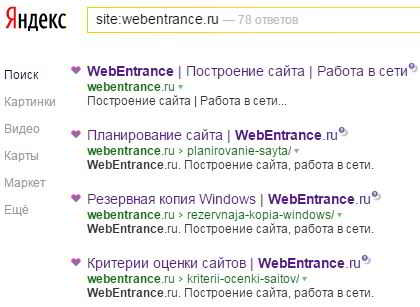

Есть два способа для поиска дублей страниц. Во-первых, копируем URL и пишем в Яндексе команду site:webentrance.ru без http.

Таким образом, Яндекс покажет нам все страницы, которые есть на данный момент в индексе.

Наша задача просмотреть в выдаче все URLы и найти подозрительные. То есть просматриваем сайт и ищем несоответствие. Возможны ошибки URL и т. д. и здесь очень просто найти дубли страниц.

Поиск дублей страниц с помощью сервисов

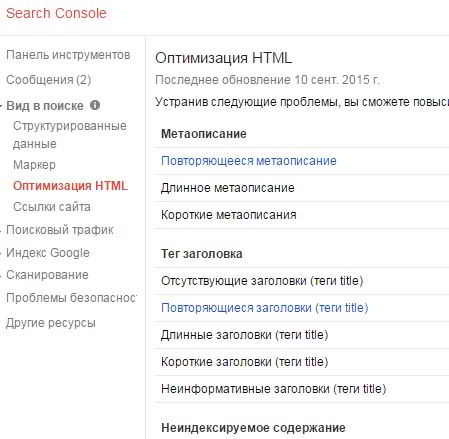

Второй способ это софт и различные сервисы, например, Google веб-мастер. Заходим в него и во вкладке Оптимизация, выбираем Оптимизация html. Нам показывают те страницы, на которых есть одинаковые мета-теги.

Скорее всего, они и являются дубликатами. Как уже было сказано, самый простой способ избавиться от дубликатов, это закрыть их в файле robots.txt.

Произойдет это конечно не сразу, но через какое-то время можно будет заметить, что дубли выбыли из индекса. Вскоре можно будет заметить эффект в позициях ресурса в поиске и трафике, поэтому это необходимо сделать.

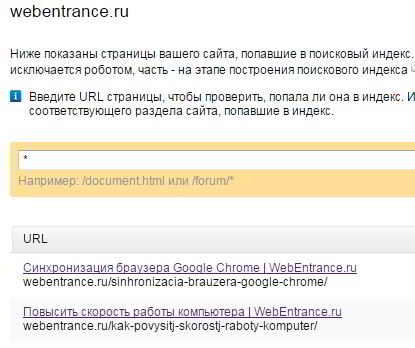

Для определения дублей страниц, уже проиндексированных поисковыми системами, можно перейти в Яндекс.Вебмастер, перейти в раздел Индексирование сайта и проверить, какие страницы ресурса находятся в поиске поисковой системы.

Здесь надо увидеть главную страницу блога, где адресом является просто домен. Затем должны быть все страницы, которые доступны в верхнем меню и все до одной статьи.

Если сайт небольшой, порядка 100 страниц, то его можно без труда просмотреть и понять, какие именно страницы находятся в индексе и ничего лишнего здесь быть не должно.

Не должно быть никаких page, категорий, никаких тегов. Здесь же можно посмотреть исключенные страницы и документы, запрещенные файлом robots.txt. Это обычно все результаты поиска и т. д.

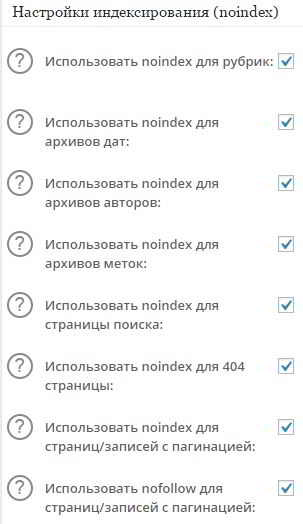

Перейдем в настройки плагина All in SEO Plugin Options и ставим галочки Использовать параметр ‘noindex’ для рубрик, для архивов, для архива меток.

Чтобы посмотреть файл robots.txt, достаточно набрать после домена через слеш robots.txt. Здесь особо ничего закрывать не надо, кроме каких-то служебных файлов.

В результате этой работы в поиске должны остаться только необходимые страницы, которые будут быстрее индексироваться поисковыми системами.